代理的作用

发布时间:2022-08-22 11:18:04

发布人:wjy

点评:顾名思义爬虫就是模仿人的行为从网页获取数据。

一个人,需要先打开浏览器、输入网址,从网站后台获取网页并加载到浏览器展示,最后才能获取数据。

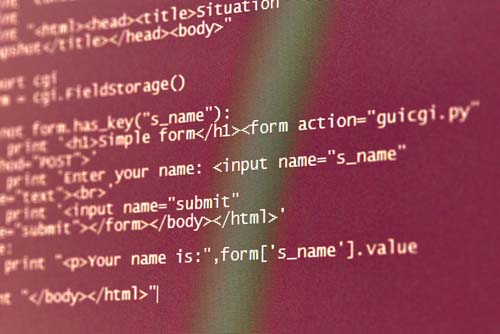

爬虫的请求部分,就相当于浏览器的角色,会根据你输入的url从网站后台获取html,而解析部分就会根据预先设定的规则,从html中获取数据。

而开发者的工作,一是装饰请求部分,例如在请求头中添加User-Agent、Cookie等,让网站觉得是一个人通过浏览器来访问的,而不是一个程序。

二是通过选择器来编写规则,从页面获取数据。

如何让对方后台服务器觉察不出来?比如添加请求头user-agent、设置延时请求、设置代理等,众所周知如果使用一个ip地址去访问,则会发现访问几次就会被封掉,Why???因为已经探测到是爬虫程序了。